Apache Spark 监控

Apache Spark 是一款专门为速度而设计的开源大数据处理框架,它拥有内置模块来执行流式处理、SQL、机器学习和图形处理。Apache Spark 带有高级 DAG 执行引擎,它支持非循环数据流和内存计算。Spark 在 Hadoop、Mesos 上运行,也可以在单机、云端运行。它可以访问各种数据源,包括 HDFS、Cassandra、HBase 和 S3。

执行一项 spark 应用程序工作需要许多组合组件。如果您计划在生产环境中部署 Spark,Applications Manager 可以确保您能够监控各个组件、了解性能参数、在出现问题时收到告警以及了解如何诊断问题。

获取 Spark 的性能

Applications Manager 可以自动发现数据管道和应用程序的完整服务拓扑。其实时提供全面的集群和节点管理,并利用工作流可视化监控 Spark 应用程序的执行。针对集群中创建的每一个应用程序,以单机模式显示在各个节点和执行进程上运行的主程序和工作程序。即时了解集群运行时的各个指标、各个节点和配置。

跟踪资源使用情况

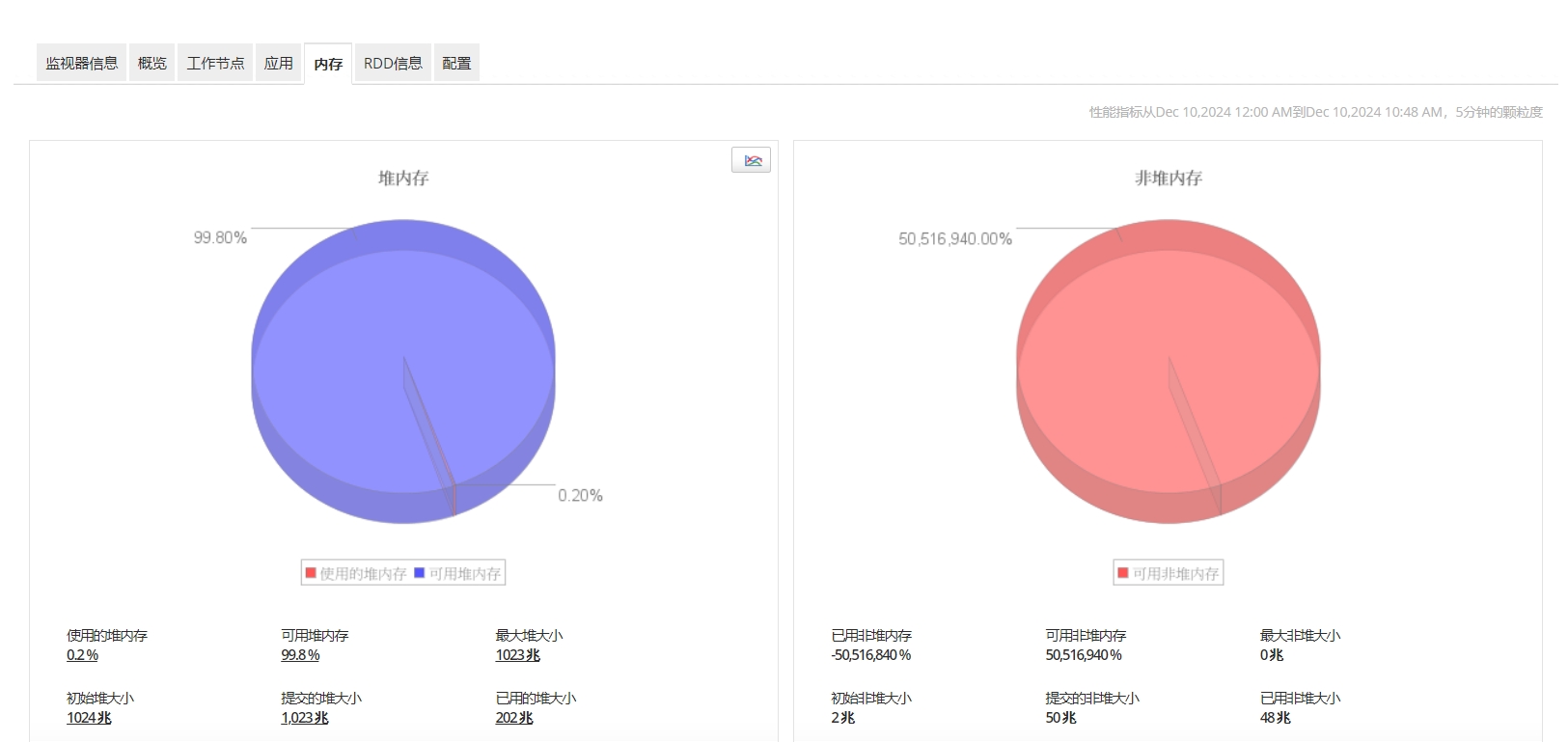

管理资源以使 Spark 应用程序的运行状况最佳。添加新作业时,操作团队必须在可用的资源与业务优先级之间进行平衡。通过粒度的性能统计信息,例如磁盘 I/O 和内存使用指标,密切关注集群运行状况;并通过所有节点的 CPU 使用率和 JVM 堆占用量,实时方式关注节点运行状况。

获取Spark 内核和应用程序详情

获取Spark 生产应用程序指标;根据用户定义的数据来组织和划分 Spark 应用程序;以及根据状态(活动、正在等待、已完成)和运行持续时间对应用程序进行排序。作业失败的原因通常是内核不足。Spark 节点/工作程序监控会提供各种指标,包括可用内核数和已用内核数,以便用户根据内核数执行资源分配。

获取 RDD 和计数器的性能

获取性能指标,包括针对给定应用程序存储的 RDD(弹性分布式数据集)、给定 RDD 的存储状态和内存状态,以及每一次 Spark 执行的所有 Spark 计数器。深入了解文件级缓存命中情况和并行作业,以便进行潜在的性能优化。

更快地修复性能问题

在 Apache Spark 组件出现性能问题时接收即时通知。了解性能瓶颈,并确定哪个应用程序导致负载过高。在终端用户遇到问题之前迅速采取补救措施。